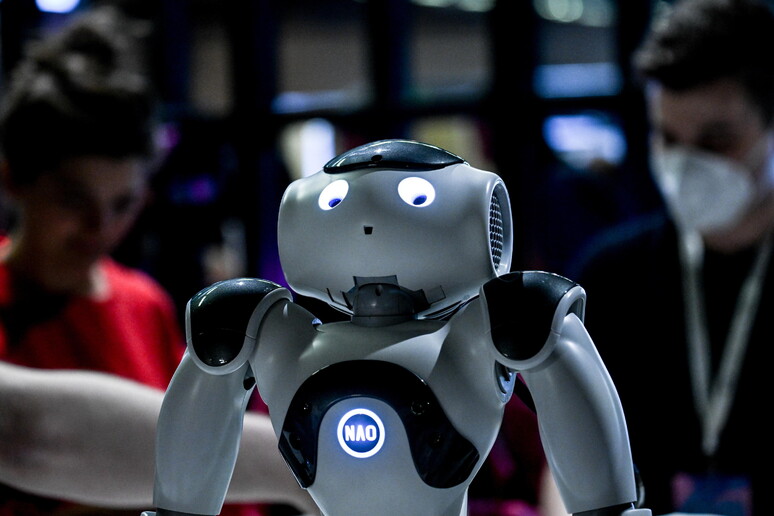

Anche i robot possono diventare razzisti e sessisti: lo dimostra un esperimento condotto negli Stati Uniti, dove un robot ha imparato ad agire secondo stereotipi comuni, associando per esempio le persone di colore alla criminalità e le donne ai lavori domestici. La colpa è del suo 'cervello', un sistema di intelligenza artificiale ampiamente diffuso e addestrato con dati presi dal web. Lo studio, condotto dalla Johns Hopkins University con il Georgia Institute of Technology e l'Università di Washington, è presentato alla conferenza FAccT 2022 dell'Association for Computing Machinery (Acm), in Corea del Sud.

"Il robot ha appreso stereotipi pericolosi attraverso modelli imperfetti di rete neurale", afferma il primo autore dello studio, Andrew Hundt. "Rischiamo di creare una generazione di robot razzisti e sessisti", avverte il ricercatore, sottolineando la necessità di affrontare la questione al più presto. Il problema è che gli sviluppatori di sistemi di intelligenza artificiale per il riconoscimento di persone e oggetti sono soliti addestrare le loro reti neurali usando set di dati disponibili gratuitamente su Internet: molti contenuti però sono imprecisi e distorti, dunque qualsiasi algoritmo costruito sulla base di queste informazioni rischia di essere fallace. Il problema è stato più volte sollevato da test ed esperimenti che hanno mostrato la scarsa efficienza di certi sistemi di intelligenza artificiale, impiegati ad esempio per il riconoscimento facciale. Finora, però, nessuno aveva provato a valutare le conseguenze di questi algoritmi fallati una volta che vengono usati per governare robot autonomi che operano nel mondo reale senza la supervisione dell'uomo.

Riproduzione riservata © Copyright ANSA